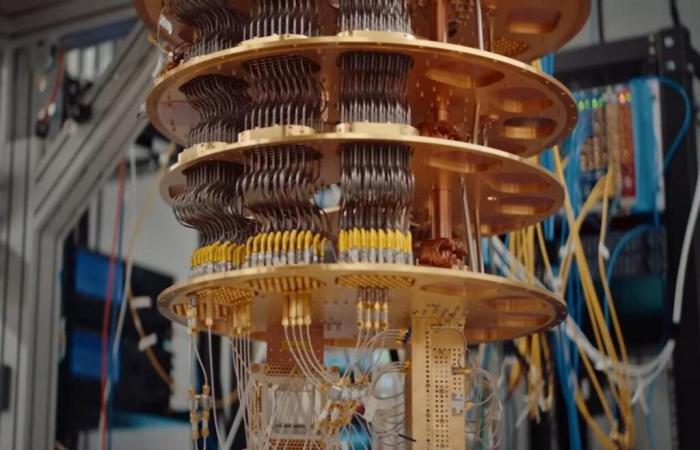

All’inizio della settimana Google ha presentato Willow, l’ultima versione del suo processore quantistico. In un post sul blog, attribuisce a questo chip da 105 qbit prestazioni assolutamente sbalorditive; in meno di 5 minuti sarebbe stata in grado di farlo risolvere problemi che richiederebbero 10 milioni di miliardi di miliardi di anni di lavoro per i migliori supercomputer attuali.

Ma c’è un problema: l’interesse pratico dei calcoli in questione è estremamente limitato, e bisognerà ancora attendere prima di raggiungere quella “supremazia quantistica” che Google ha avuto l’audacia di rivendicare nel 2019.

L’RCS, un benchmark non necessariamente rilevante

Per capire cosa rende discutibile questo annuncio, dobbiamo guardare la metrica utilizzata da Google: campionamento a circuito casuale, o RCS (per Campionamento di circuiti casuali). Questo test prevede la generazione di sequenze casuali di porte logiche quantistiche che verranno scritte in un insieme di qbit, le unità logiche fondamentali del calcolo quantistico. Campionando più volte questi circuiti, il sistema produce poi serie di bit la cui distribuzione statistica dipende dalla configurazione del circuito.

Questo è tradizionalmente un esercizio molto faticoso per l’informatica classica, perché la complessità dei calcoli aumenta esponenzialmente con il numero di porte logiche. In altre parole, i supercomputer convenzionali diventeranno rapidamente obsoleti.

D’altra parte, questo problema è molto più accessibile per i computer quantistici. I Qbit sono entità quantistiche che possono esistere in una sovrapposizione di stati diversi; in altre parole, a differenza dei bit nell’informatica tradizionale, non sono limitati a un unico valore preciso, come 0 o 1. Questa sovrapposizione quantistica consente invece loro di esistere in stati intermedi. E soprattutto, in condizioni ideali, tutti questi qbit sono correlati in virtù dell’entanglement quantistico – il famoso “ azione spaventosa a distanza » menzionato da Einstein.

Questa combinazione di sovrapposizione ed entanglement è al centro del funzionamento di un computer quantistico. Permette alla macchina di elaborare informazioni diverse in paralleloe quindi di risolvere problemi molto complessi come RCS in tempi estremamente brevi rispetto ai supercomputer tradizionali.

Iscriviti al Journal du Geek

Ma se si tratta effettivamente di un esercizio molto impegnativo da un punto di vista strettamente computazionale, l’RCS non è necessariamente il punto di riferimento più rilevante quando si tratta di confrontare le prestazioni di un computer quantistico con quelle di un supercomputer convenzionale. In effetti, ad eccezione di alcune applicazioni di nicchia in aree come la crittografia, questo test non ha funzionato quasi nessun uso pratico nel mondo reale. Abbastanza noioso, considerando che l’obiettivo principale dei leader dell’informatica quantistica è consentire a queste macchine di risolvere i problemi del mondo reale.

Nonostante i limitati vantaggi pratici di questo approccio, Google continua a sostenere che tutti i computer quantistici dovrebbero essere giudicati in base alle loro prestazioni RCS. Non c’è da stupirsi, visto che l’azienda di Mountain View è ormai dominante in questo campo… e anche questo glielo permetteevitare confronti diretti con i principali concorrenti. In effetti, molti grandi nomi dell’informatica quantistica, come IBM, tendono a basarsi su un altro parametro: volume quanticoche stima la capacità del sistema di eseguire algoritmi generali. Tuttavia, il comunicato stampa di Google evita accuratamente di fare riferimento a questo indicatore.

Enormi progressi nella gestione degli errori

Questo però non significa che questo lavoro non abbia alcun valore, perché Google sostiene ancora grandi progressi su un punto molto importante: la correzione degli errori.

A causa della loro dipendenza dagli stati di sovrapposizione e di entanglement, i qbit sono oggetti molto delicati. La minima variazione nell’ambiente può introdurre errori che devono essere corretti in seguito. Tuttavia, preservare l’integrità del sistema diventa sempre più difficile quando la sua potenza aumenta; maggiore è il numero di qbit, più difficile è prevenire errori.

Ma Google sembra essere riuscita ad aggirare questo ostacolo; l’azienda sostiene infatti la robustezza della sua architettura Willow aumenta esponenzialmente invece di diminuire quando si introducono nuovi qbit !

“Abbiamo testato array di qubit fisici sempre più grandi, passando da una griglia di qubit 3×3 a una griglia 5×5, quindi 7×7. Ogni volta, grazie ai nostri progressi nella correzione quantistica degli errori, siamo riusciti a dimezzare il tasso di errore. In altre parole, abbiamo ottenuto una riduzione esponenziale del tasso di errore. Questo risultato storico è noto nel settore come “sottosoglia”: riduce gli errori aumentando il numero di qubit”, si legge nel comunicato stampa.

La ciliegina sulla torta è che questo sistema di correzione è in grado di operare in tempo reale – un punto molto importante per l’integrità dei dati in uscita, e quindi per considerare possibili applicazioni pratiche.

Sarà molto interessante vedere se Google deciderà mai di uscire dalla sua zona di comfort di RCS, per mostrare cosa ha in serbo Willow quando si tratta di risolvere problemi più banali e arrivare al famoso “.supremazia quantistica” cosa che l’azienda aveva già sostenuto – erroneamente – nel 2019.

???? Per non perdere nessuna notizia sul Journal du Geek, iscriviti su Google News. E se ci ami, abbiamo una newsletter ogni mattina.