Con Phi-4, Microsoft dimostra ancora una volta che è possibile conciliare prestazioni e compattezza. Questo SLM da 14 miliardi di parametri che secondo l’azienda “eccelle nel ragionamento complesso in aree come la matematica, oltre all’elaborazione del linguaggio convenzionale”è riuscito a superare modelli all’avanguardia come Gemini Pro 1.5, GPT-4o o Claude 3.5 Sonnet su alcuni benchmark.

Mentre abbiamo assistito all’arrivo di LLM con un numero di parametri sempre più impressionante, alcuni player di intelligenza artificiale come Mistral AI o Google offrono ora modelli molto più compatti. Microsoft, con i suoi modelli Phi, si è interessata alle potenzialità degli SLM dall’aprile 2023. Mentre ha presentato i modelli Phi-3.5: Phi-3.5-mini-instruct, Phi-3.5-MoE-instruct e Phi-3.5-vision- istruire, ciascuno ottimizzato per compiti specifici, lo scorso agosto ha introdotto Phi-4.

Secondo Microsoft, il motivo per cui Phi-4 supera modelli paragonabili e più grandi nel ragionamento matematico è dovuto ai progressi compiuti dallo sviluppo di Phi-3.5. Spiega questo progresso dicendo:

- L’uso di dati sintetici di alta qualità, che arricchiscono le capacità del modello;

- Processi post-formazione innovativi, ottimizzando le risposte per compiti specifici;

- Cura rigorosa dei dati organici per mantenere la rilevanza linguistica.

Possiamo vedere nell’immagine qui sotto che supera significativamente le prestazioni di LLama-3.1-8B_Instruct e le sue prestazioni sono leggermente inferiori a quelle di LLama-3.3-70B-Instruct.

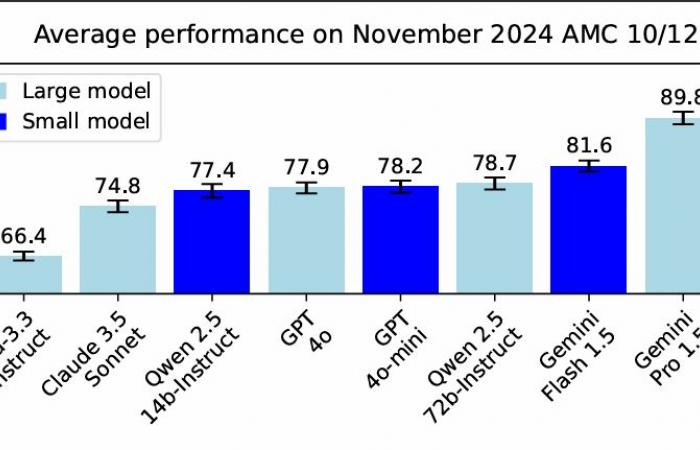

Microsoft ha valutato le proprie prestazioni in base ai benchmark delle competizioni di matematica ospitate dalla Mathematical Association of America (MAA), inclusi i test AMC 10/12, progettati per valutare le competenze degli studenti delle scuole superiori in trigonometria, algebra, geometria e probabilità.

Phi-4 ha ottenuto risultati impressionanti, superando modelli più grandi come Gemini Pro 1.5, Claude 3.5 Sonnet e GPT-4o, come si può vedere in questo grafico.

Phi-4 è disponibile con un contratto di licenza di ricerca tramite Azure AI Foundry. Presentata a Ignite 2024 il mese scorso, questa piattaforma fornisce solidi strumenti per valutare, mitigare e gestire i rischi dell’IA, garantendo un utilizzo sicuro del modello. Questo sarà accessibile anche su Hugging Face nei prossimi giorni.