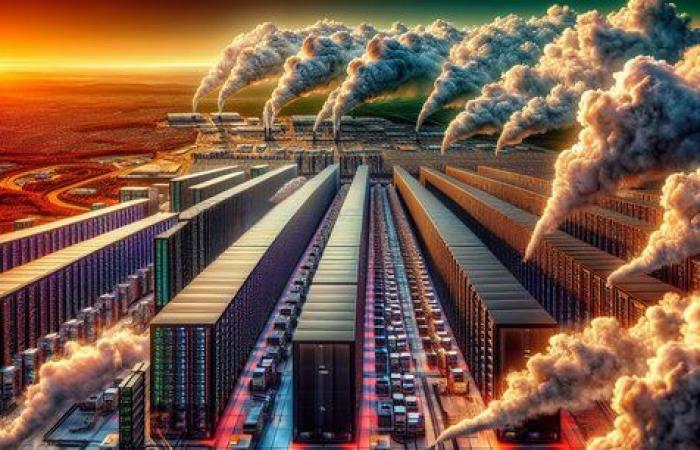

Possiamo continuare ad aumentare le prestazioni dell’intelligenza artificiale senza mettere a rischio il nostro pianeta? Nelle ultime settimane i segnali d’allarme si sono moltiplicati. OpenAI, il creatore di ChatGPT, ha recentemente avvertito la Casa Bianca che ciascuno dei suoi futuri data center richiederebbe probabilmente “ più energia di quanta ne venga utilizzata per alimentare un’intera città”.

Lo stesso mese, la società energetica Constellation Energy e Microsoft hanno firmato un accordo ventennale per la riapertura della centrale nucleare di Three Mile Island in Pennsylvania, luogo del più grave incidente radiologico che gli Stati Uniti abbiano mai subito. Da parte sua, Google ha ammesso che sta lottando per raggiungere i suoi obiettivi di neutralità del carbonio.

“L’utilizzo dell’intelligenza artificiale è una questione di vita o di morte per un’azienda” (Emilie Sidiqian, direttrice francese di Salesforce)

La tendenza si sta diffondendo negli Stati Uniti, dove vengono sviluppati la maggior parte dei principali modelli di IA generativa. Tanto che un rapporto BloombergNEF avverte che i progressi del Paese sulla decarbonizzazione stanno rallentando. Le emissioni verrebbero ridotte solo del 34% entro il 2030 rispetto ai livelli del 2005, ben lontani dall’obiettivo del 50-52%. La causa secondo questo rapporto: la bulimia dell'intelligenza artificiale in materia di energia.

Una marcia forzata di democratizzazione

“Tutti i giganti del web investono nelle infrastrutture, dando priorità alle prestazioni dei modelli e trascurando i costi energetici”, riassume Tristan Nitot, direttore associato di OCTO Technology, specialista in digitale sostenibile. Qualche settimana fa, Eric Schmidt, ex capo di Google e grande investitore nel campo dell’intelligenza artificiale, ha messo da parte l’argomento durante una conferenza. “Non raggiungeremo gli obiettivi nonostante tutto perché non siamo organizzati per farlo. I requisiti energetici dell’intelligenza artificiale saranno problematici, ma preferirei scommettere che l’intelligenza artificiale risolva la crisi ambientale piuttosto che forzarla e avere il problema a prescindere da tutto. »

Ma questa scommessa tecno-soluzionista è sostenibile data la rapida democratizzazione dell’intelligenza artificiale, e quindi il suo crescente costo energetico? L’intelligenza artificiale generativa viene ora integrata in prodotti molto diffusi. Pensate alla nuova versione di iOS, dotata di “Apple Intelligence” che riassume velocemente le vostre notifiche e messaggi in una frase, o all’AI Overviews di Google che offre agli internauti di un centinaio di paesi un riepilogo dei risultati architettato dall’IA. della loro ricerca… Da ora in poi, l'uso di ChatGPT e altri solleva interrogativi. Secondo l’Agenzia internazionale per l’energia (IEA), una richiesta al chatbot OpenAI consumerebbe quasi dieci volte più elettricità di una semplice query su Google.

A questo impatto si aggiunge quello più noto della formazione. Questa è la fase in cui i modelli di intelligenza artificiale “leggono” una grande quantità di dati e poi si esercitano a rispondere alle domande. Questo lavoro richiede diversi giorni, persino settimane di calcoli e una colossale massa di dati. A peggiorare le cose, le infrastrutture necessarie si trovano principalmente in paesi in cui l’energia rimane ad alta intensità di carbonio, come gli Stati Uniti, l’Irlanda, ma anche la Germania.

Come Theremia utilizza l'intelligenza artificiale per ottimizzare l'efficacia dei farmaci

Ma come sottolinea Tristan Nitot, “Non è solo una questione di elettricità”. Anche il consumo di acqua è una questione centrale. Per raffreddare i data center surriscaldati, Big Tech utilizza torri di raffreddamento che consumano oro blu. Pertanto, il consumo di acqua di Microsoft è aumentato di un terzo rispetto al 2021 e del 21% per Google. “Dobbiamo anche pensare all’intero ciclo di vita dell’IA, aggiunge. Si inizia con l’estrazione dei metalli, poi il loro trasporto verso le fabbriche che producono i trasformatori necessari al loro sviluppo, a Taiwan in particolare”. E il consumo di processori sta esplodendo, spinto dal rinnovamento dell’hardware del computer per renderlo compatibile con le funzionalità dell’intelligenza artificiale.

Di fronte a questa constatazione mortale, l’industria tecnologica non resta inattiva. Nvidia è orgogliosa di migliorare costantemente l'efficienza energetica delle sue GPU, questi chip essenziali per addestrare la migliore intelligenza artificiale. I data center stanno adottando nuove tecnologie di raffreddamento chiamate “raffreddamento diretto”, che consistono nell’infiltrare direttamente nei server un liquido a temperatura ambiente. Una tecnica che consuma meno acqua ed elettricità.

La paura dell’effetto rimbalzo

“Stiamo assistendo a miglioramenti impressionanti, ma non abbiamo mai consumato così tanto carbone nella storia umana. Non vedo perché l'intelligenza artificiale dovrebbe sfuggire al paradosso di Jevons.” Tuttavia, ritiene Gaël Varoquaux, ricercatore dell'Inria. Questo paradosso, chiamato anche “effetto rimbalzo”, afferma che poiché i miglioramenti tecnologici aumentano l’efficienza con cui viene utilizzata una risorsa, il consumo totale di quella risorsa aumenta anziché diminuire.

Anche dal punto di vista software i progressi sono visibili. La tendenza è quella di sviluppare modelli piccoli, altrettanto efficaci per determinati casi d’uso, ma che richiedono una potenza di calcolo fino a dieci volte inferiore. Queste piccole IA hanno anche il vantaggio di poter funzionare sull’hardware tradizionale dei computer, come uno smartphone o un computer.

Al di là di questi progressi tecnici, sarà necessario “disciplinati” nelle parole di Gilles Babinet, presidente del Consiglio Nazionale del Digitale. “Dobbiamo smettere di aggiornare costantemente i modelli, perché il costo energetico della loro formazione rimane il problema principale, favorire un’intelligenza artificiale più specifica e discriminare certi usi stupidi o inutili”, dice.

Intelligenza artificiale: la rabbia degli artisti

Ma mentre i giganti digitali volevano venderci un’intelligenza artificiale generativa ovunque, questi usi meno utili fanno già parte della vita quotidiana di alcuni. Pierre-Yves Oudeyer, direttore della ricerca dell’Inria, particolarmente interessato all’uso dell’intelligenza artificiale generativa tra i giovani, osserva che questa tecnologia a volte serve loro da“interfaccia universale”. Gli chiedono informazioni come il risultato di una partita di basket, la capitale di un paese, che una semplice ricerca su Google avrebbe facilmente fornito. “È come usare un bulldozer per schiacciare una mosca”, riassume. Per lui, educare gli utenti alle questioni ambientali è essenziale per razionalizzare gli usi. Dopo la vergogna di volare, ci sentiremo in colpa per ogni richiesta ChatGPT?