Nome in codice: Olimpo. Progetto: un modello multimodale in grado di elaborare contemporaneamente immagini, video e testo. Obiettivo: acquisire l’indipendenza. Ecco in poche parole le linee generali del piano di Amazon in termini di intelligenza artificiale.

Come riportato, il colosso del cloud e dell’e-commerce vuole effettivamente avere un proprio LLM L’informazione. Se per il momento si sa poco di questo modello, c’è da scommettere che l’azienda farà luce sull’argomento la prossima settimana durante il suo evento annuale AWS re:Invent a Las Vegas.

Un modello con 2000 miliardi di parametri

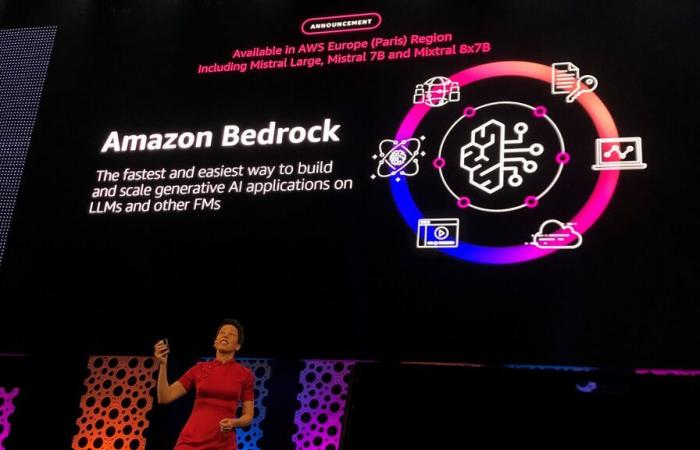

Il modello, tra le altre cose, comprenderebbe le scene presenti in immagini e video e aiuterebbe i clienti a cercare scene specifiche, come il tiro di una partita di basket vincente, utilizzando semplici comandi di testo. Composto da 2.000 miliardi di parametri, supererebbe quindi GPT-4, il modello OpenAI che conta 1.000 miliardi di parametri e diventerebbe di fatto il modello “più grande” esistente. Sarebbe disponibile anche su Bedrock, il servizio di intelligenza artificiale generativa dedicato di AWS.

L’anno scorso, durante l’ultima edizione della sua conferenza annuale, AWS ha presentato in anteprima il modello Amazon Titan Image Generator per Bedrock. Quest’ultimo “può essere utilizzato per generare e ripetere rapidamente immagini a basso costo, può comprendere messaggi complessi e generare immagini pertinenti con una composizione accurata degli oggetti e distorsioni limitate”, specifica il fornitore di servizi cloud. L’azienda aveva già diversi modelli di intelligenza artificiale generativa nel suo portafoglio, tra cui Titan Text Lite e Titan Text Express.

Elimina gradualmente i LLM sviluppati da terze parti

Offrendo il proprio modello multimodale, Amazon cerca di ridurre la sua dipendenza dalla famiglia di modelli Claude sviluppata dalla start-up Anthropic. Le due società ormai si conoscono bene, come dimostra il secondo aiuto finanziario ricevuto dalla start-up. Questo finanziamento fornito da Amazon per un importo di quattro miliardi di dollari dovrebbe aiutare la giovane azienda ad andare avanti nello sviluppo dei suoi prodotti e modelli di intelligenza artificiale.

In cambio, il rivale di OpenAI fa un’importante concessione e adotta i chip AWS per l’addestramento e l’inferenza dei suoi modelli. Un’altra considerazione: Anthropic fornisce ai clienti AWS l’accesso ai suoi modelli – inclusa la famiglia di modelli Claude 3 –, in particolare tramite Amazon Bedrock.

Allo stesso tempo, Amazon prevede di affidarsi a Claude per la prossima versione del suo assistente Alexa per renderlo capace di rispondere a richieste complesse. Ovviamente il colosso intende monetizzare questa offerta. Non è però chiaro se Amazon dovrà pagare un supplemento ad Anthropic per l’utilizzo di Claude in Alexa. Ed è ancora possibile che tutto cambi con l’arrivo dell’Olimpo. Continua.

Selezionato per te